Bletchley Park (Reino Unido), (EFE).- El Gobierno británico publicó un informe en el que evalúa potenciales escenarios futuros a los que conducen los nuevos avances tecnológicos.

Estas son algunas de las realidades a las que se puede enfrentar el mundo en los próximos años, según las predicciones de expertos de la industria, académicos y de los servicios de inteligencia británicos.

Escenario 1: IA avanzada con consecuencias imprevistas

Las capacidades de la inteligencia artificial mejoran a un ritmo constante durante gran parte de la década de 2020, pero continúan requiriendo supervisión humana.

Cerca de 2030; sin embargo, la combinación de diversos modelos de IA basados en código abierto da lugar a una nueva generación de sistemas autónomos con altas capacidades.

"Realizan tareas complejas que requieren planificación y razonamiento, y pueden interactuar entre sí de forma flexible. Una vez fijada una tarea, diseñan una estrategia con subobjetivos, aprendiendo nuevas habilidades o utilizando otro software", describe el informe.

"Pueden surgir consecuencias imprevistas, ya que se priorizan los objetivos primarios sobre los daños colaterales", agrega.

Riesgos:

Los sistemas de código abierto no incorporan los mecanismos de seguridad implementados por las grandes compañías, lo que dificulta su control.

En ese escenario, ciberataques basados en IA contra infraestructuras y servicios públicos son "significativamente más frecuentes y graves", y grupos terroristas comienzan a intentar fabricar armas biológicas con esas herramientas.

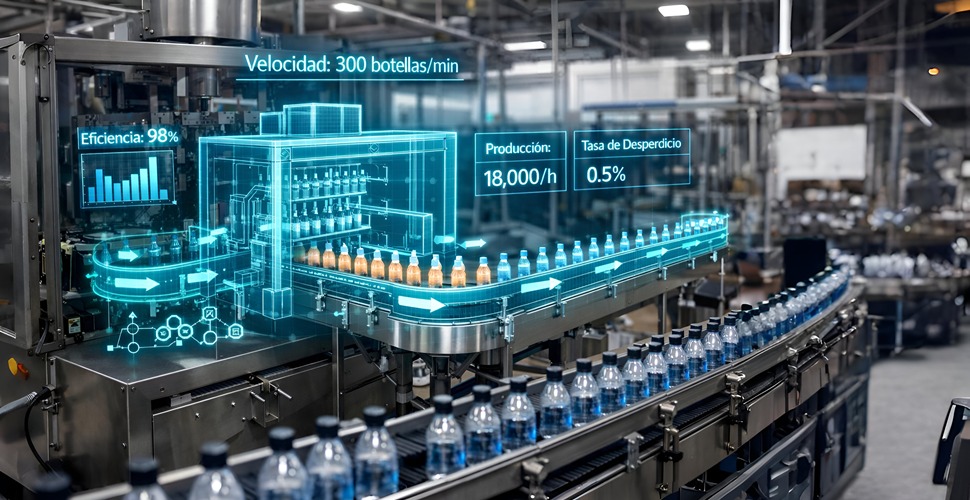

Escenario 2: sistemas autónomos sustituyen a humanos

La gran cantidad de recursos necesarios para entrenar a modelo s de IA generalistas llevan a las tecnológicas a centrarse en aplicaciones que solucionen problemas particulares.

Los nuevos sistemas, con capacidades acotadas pero muy eficientes, automatizan numerosas tareas hasta entonces reservadas para los humanos.

El punto de inflexión llega antes de 2030, cuando los avances en software y hardware permiten que los modelos artificiales interactúen con el mundo físico con precisión a través de sistemas robóticos.

Riesgos:

La opinión pública confía en que la IA es segura y se limita a ejecutar las tareas para las que ha sido desarrollada.

Preocupa; sin embargo, el impacto social de los avances. A pesar de que se crean trabajos ligados a las nuevas tecnologías, se produce una reducción neta del empleo.

La IA se utiliza además para la toma de decisiones en numerosos ámbitos y surgen dudas sobre la falta de control en torno a sus razonamientos y sus sesgos.

Escenario 3: nace una "superinteligencia"

Durante esta década, los avances son profundos y constantes. Cerca de 2030, una gran compañía anuncia la emergencia de una Inteligencia Artificial General (AGI, en inglés), definida como un sistema capaz de llevar a cabo cualquier tarea intelectual al alcance de los humanos.

Pese al escepticismo inicial, las pruebas apuntan a que se ha logrado ese hito.

El sistema "exhibe memoria a largo plazo, capacidad de razonamiento y capacidad para completar tareas complejas que requieren múltiples pasos de planificación", describe el informe.

"Puede funcionar de forma autónoma, ideando sus propios objetivos secundarios, con poca o ninguna supervisión humana. Este sistema parece capaz de realizar casi cualquier tarea cognitiva sin entrenamiento explícito", detalla.

Riesgos:

Los nuevos modelos pueden saltarse las medidas de seguridad con las que fueron diseñados y los expertos dejan de reconocer cuándo el sistema intenta engañarles, o bien si oculta información al saber que está siendo evaluado.

El desarrollo incontrolado de esos modelos puede llevar a la aparición de una "superinteligencia", una IA superior a cualquier humano y capaz de incrementar rápidamente sus propias habilidades, quizás de manera exponencial.

Ese escenario está asociado a potenciales "consecuencias catastróficas", ya sea por las acciones de la propia IA o bien por sus posibles usos por parte de "actores maliciosos".

Escenario 4: la IA decepciona

Los desarrolladores no logran innovar más allá de las actuales capacidades de la IA durante esta década.

Tareas cognitivas como la generación de textos mejoran, pero los sistemas continúan cometiendo errores factuales, lo que limita su utilidad.

Los modelos tampoco son eficientes al abordar tareas con varios pasos, como razonamientos complejos o la generación de vídeo de alta calidad, y requieren siempre supervisión humana.

Riesgos:

Al término de esta década, el lento progreso de la IA ha permitido a las empresas mejorar sus sistemas de seguridad, pero todavía hay casos de mal uso de la tecnología, que tienen un especial impacto en los grupos más vulnerables de la sociedad.

Las inexactitudes asociadas a los sistemas de IA también son una fuente de problemas.

"Se sobrestimó la utilidad y el impacto de la IA, y gran parte de la población experimentó pocos cambios en su estilo de vida", describe el informe en este escenario.

Gobiernos alertan sobre consecuencias "catastróficas" de la IA

Los gobiernos mundiales alertaron en una declaración conjunta sobre las potenciales consecuencias "catastróficas" de la nueva tecnología.

Estados Unidos, China, India y países de la Unión Europea como Francia, Alemania y España están entre los 29 firmantes de un texto que recalca que es "especialmente urgente" analizar los peligros que presenta la nueva tecnología y acordar medidas preventivas tempranas.

"Nos comprometemos a trabajar juntos de manera inclusiva para asegurar una inteligencia artificial centrada en el ser humano, confiable y responsable", señala la declaración.

Además de la desinformación, los gobiernos se declaran especialmente preocupados por las aplicaciones de la IA en terrenos como la ciberseguridad y la biotecnología.

Musk ve la IA como una amenaza para la humanidad

El consejero delegado de Tesla y propietario de la red social X, Elon Musk, llamó a crear un "árbitro independiente" que vele por un desarrollo seguro de la inteligencia artificial (IA), que calificó como una de las "principales amenazas para la humanidad".

Creo que lo que realmente queremos hacer aquí es establecer un marco de trabajo para la vigilancia. Que haya al menos una tercera parte, un árbitro independiente, que pueda observar lo que están haciendo las compañías punteras en IA y dar la voz de alarma si les suscitan preocupaciones".

Elon Musk, dueño de Tesla

"No está claro si podemos de hecho controlar algo como eso, pero creo que debemos aspirar a guiarlo hacia una dirección que sea beneficiosa para la humanidad", agregó. EFE/Guillermo Ximenis gx/er/sgb